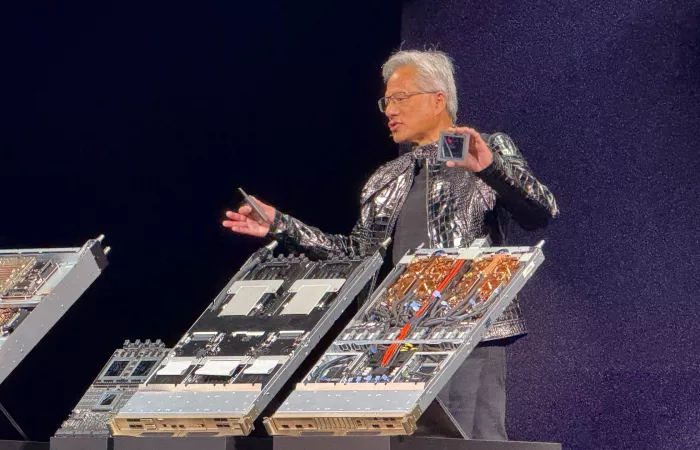

La piattaforma Vera Rubin non è una semplice evoluzione delle GPU, ma un sistema complesso che integra Rubin GPUs, Vera CPUs, interconnessioni NVLink 6, DPUs BlueField 4 e switch Ethernet Spectrum 6, creando soluzioni complete per i data center. Ogni rack include 72 Rubin GPUs e 36 Vera CPUs, offrendo performance superiori fino a 50 PFLOPS per l'inferenza AI.

Questa strategia risponde alle esigenze dei grandi clienti di Nvidia, come gli hyperscalers e i laboratori AI, che richiedono soluzioni pre-integrate per accelerare i tempi di deployment e ridurre i costi. Inoltre, si evidenzia un crescente interesse per i modelli di AI con contesti estesi, supportati da un'innovativa gestione della memoria.

L'assenza di nuove GPU GeForce al CES si spiega con la freschezza della gamma attuale e i prezzi elevati. Nvidia sembra orientarsi verso un ciclo più lungo di aggiornamenti delle GPU, con focus su miglioramenti a livello di sistema invece che su incrementi di performance grafica.

Cosa distingue la piattaforma Vera Rubin dalle precedenti soluzioni GPU di Nvidia?

La piattaforma Vera Rubin rappresenta un'evoluzione significativa rispetto alle tradizionali GPU di Nvidia, integrando sei nuovi chip: CPU Vera, GPU Rubin, switch NVLink 6, SuperNIC ConnectX-9, DPU BlueField-4 e switch Ethernet Spectrum-6. Questa combinazione offre una soluzione completa per i data center, con prestazioni di inferenza fino a 5 volte superiori e costi per token 10 volte inferiori rispetto alla precedente architettura Blackwell.

Quali sono le specifiche tecniche principali del supercomputer AI Vera Rubin NVL72?

Il Vera Rubin NVL72 è composto da 72 GPU Rubin e 36 CPU Vera, offrendo una memoria GPU totale di 20,7 TB con una larghezza di banda fino a 28,8 TB/s. Le prestazioni includono 3.600 PFLOPS per l'inferenza NVFP4 e 2.520 PFLOPS per il training NVFP4. Inoltre, il sistema utilizza interconnessioni NVLink 6 per migliorare la comunicazione e la scalabilità delle reti.

Perché Nvidia ha scelto di non annunciare nuove GPU GeForce al CES 2026?

Nvidia ha deciso di non presentare nuove GPU GeForce al CES 2026 a causa della recente introduzione della gamma attuale e dei prezzi elevati. L'azienda sta orientando la sua strategia verso cicli di aggiornamento più lunghi per le GPU, concentrandosi su miglioramenti a livello di sistema piuttosto che su incrementi di performance grafica.

Quali sono i vantaggi dell'architettura rack-scale per l'AI introdotta da Nvidia?

L'architettura rack-scale per l'AI di Nvidia, come implementata nel Vera Rubin NVL72, offre vantaggi significativi in termini di scalabilità, efficienza energetica e facilità di deployment. Integrando componenti pre-progettati e ottimizzati, questa soluzione consente ai data center di accelerare i tempi di implementazione e ridurre i costi operativi.

Come si confronta il Vera Rubin NVL72 con le soluzioni AI concorrenti sul mercato?

Il Vera Rubin NVL72 offre prestazioni di inferenza fino a 5 volte superiori e costi per token 10 volte inferiori rispetto alle precedenti architetture di Nvidia, come Blackwell. Rispetto alle soluzioni concorrenti, come l'AMD MI355X DLC rack che offre 2,4 Exaflop a precisione FP4, il Vera Rubin NVL72 si distingue per l'integrazione di sei nuovi chip e un'architettura rack-scale ottimizzata per l'AI.

Quali sono le implicazioni dell'assenza di nuove GPU GeForce per il mercato consumer?

L'assenza di nuove GPU GeForce al CES 2026 indica che Nvidia sta adottando un approccio più focalizzato sull'AI e sulle soluzioni per data center. Per il mercato consumer, ciò potrebbe tradursi in cicli di aggiornamento più lunghi per le GPU GeForce, con un'attenzione maggiore a miglioramenti software e ottimizzazioni piuttosto che a nuovi lanci hardware frequenti.