Con un punteggio di 1.038 TPS per utente, Nvidia ha superato del 31% il precedente record di 792 TPS detenuto da SambaNova. Altri competitor come Amazon e Groq hanno raggiunto circa 300 TPS per utente, mentre aziende come Google e Azure hanno ottenuto risultati inferiori ai 200 TPS per utente.

Il successo di Blackwell è stato possibile grazie a numerose ottimizzazioni, tra cui l'uso di TensorRT e tecniche di speculative decoding, che hanno quadruplicato le prestazioni rispetto ai risultati precedenti. L'accuratezza è stata migliorata impiegando dati FP8 e la tecnica Mixture of Experts.

Il TPS per utente è una metrica di performance fondamentale per i software basati su LLM come Copilot e ChatGPT, influenzando la velocità di risposta degli AI chatbot. Più veloce è il processamento dei token per utente da parte di un cluster GPU, migliore sarà l'esperienza utente.

Cosa significa 'tokens per secondo' (TPS) nel contesto dell'intelligenza artificiale?

Nel contesto dell'intelligenza artificiale, 'tokens per secondo' (TPS) indica la velocità con cui un modello di linguaggio genera o elabora unità di testo, chiamate 'token'. Un token può essere una parola, un carattere o una parte di parola, a seconda del modello utilizzato. Un TPS più elevato implica una risposta più rapida da parte del modello, migliorando l'esperienza utente in applicazioni come chatbot e assistenti virtuali.

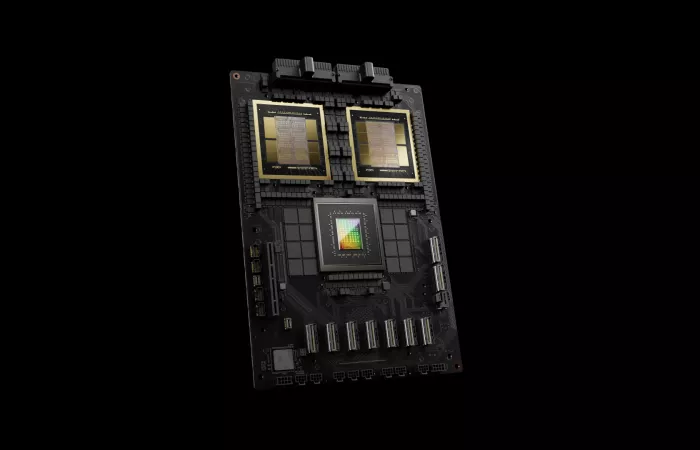

Quali sono le caratteristiche principali del nodo DGX B200 di Nvidia?

Il nodo DGX B200 di Nvidia è dotato di otto GPU Blackwell, offrendo prestazioni di 76 petaFLOPS per l'addestramento a precisione FP8 e 144 petaFLOPS per l'inferenza. Dispone di 1.440 GB di memoria GPU totale e supporta tecnologie avanzate come TensorRT per l'ottimizzazione delle prestazioni dei modelli di intelligenza artificiale. Questo sistema è progettato per applicazioni di intelligenza artificiale su larga scala, garantendo alta velocità e efficienza.

Come ha migliorato Nvidia le prestazioni del modello Llama 4 Maverick?

Nvidia ha migliorato le prestazioni del modello Llama 4 Maverick implementando ottimizzazioni come l'uso di TensorRT e tecniche di 'speculative decoding'. Queste strategie hanno quadruplicato le prestazioni rispetto ai risultati precedenti, consentendo al modello di raggiungere oltre 1.000 tokens per secondo per utente. Inoltre, l'accuratezza è stata migliorata utilizzando dati FP8 e la tecnica 'Mixture of Experts'.

Cos'è la tecnica 'speculative decoding' e come migliora le prestazioni dei modelli di linguaggio?

La 'speculative decoding' è una tecnica che accelera l'inferenza dei modelli di linguaggio generando in anticipo una serie di token candidati e verificandoli successivamente con il modello principale. Questo approccio riduce il tempo di elaborazione, aumentando il throughput fino a 3,6 volte rispetto ai metodi tradizionali. È particolarmente utile per applicazioni che richiedono risposte rapide, come chatbot e assistenti virtuali.

Quali sono i vantaggi dell'utilizzo di dati FP8 nell'addestramento dei modelli di intelligenza artificiale?

L'utilizzo di dati FP8 (floating point a 8 bit) nell'addestramento dei modelli di intelligenza artificiale offre vantaggi significativi in termini di efficienza computazionale e riduzione del consumo di memoria. Questa precisione ridotta consente di accelerare l'addestramento e l'inferenza dei modelli senza compromettere significativamente l'accuratezza, rendendo possibile l'elaborazione di modelli più complessi su hardware con risorse limitate.

In che modo la tecnica 'Mixture of Experts' contribuisce al miglioramento delle prestazioni dei modelli di linguaggio?

La tecnica 'Mixture of Experts' (MoE) migliora le prestazioni dei modelli di linguaggio suddividendo il compito di previsione tra diversi 'esperti' specializzati in sottocompiti specifici. Un 'gate' apprende a selezionare dinamicamente quale esperto utilizzare per ogni input, ottimizzando l'accuratezza e l'efficienza del modello. Questo approccio consente di gestire modelli di grandi dimensioni in modo più efficace, migliorando sia la velocità che la qualità delle risposte generate.