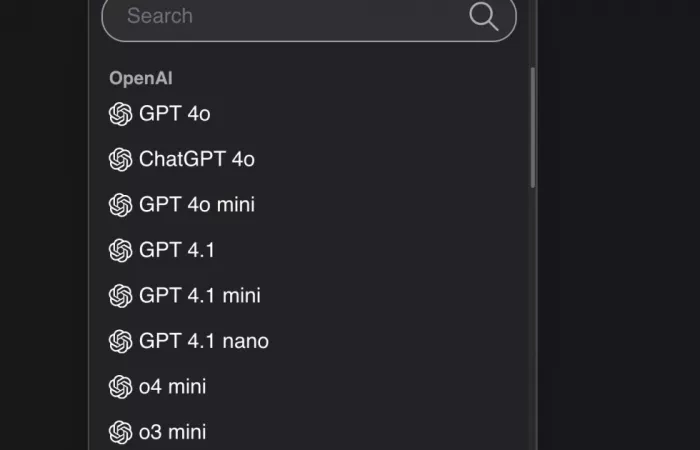

OpenAI ha rilasciato un documento che delinea le capacità specifiche dei suoi sei modelli di intelligenza artificiale noti come LLMs (Large Language Models). Questi modelli, sebbene con nomi poco intuitivi come GPT-4o e OpenAI o4-mini, sono progettati per eccellere in diversi compiti.

Cosa significa il termine 'allucinazione' in riferimento ai modelli di intelligenza artificiale?

Nel contesto dell'intelligenza artificiale, un' 'allucinazione' si riferisce a quando un modello genera informazioni inesatte o completamente inventate, presentandole come se fossero corrette. Questo può accadere quando il modello interpreta erroneamente i dati di input o tenta di rispondere a domande al di fuori della sua conoscenza.

Quali sono le principali differenze tra GPT-4o e GPT-4.5?

GPT-4o è un modello multimodale in grado di gestire input e output in testo, immagini e audio, con una finestra di contesto di 128.000 token e una conoscenza aggiornata fino a ottobre 2023. GPT-4.5, rilasciato successivamente, ha migliorato le capacità di ragionamento e problem-solving, una memoria contestuale superiore e un'integrazione web in tempo reale, con una conoscenza aggiornata fino a ottobre 2024.

Per quali tipi di compiti è più adatto OpenAI o4-mini rispetto ad altri modelli?

OpenAI o4-mini, essendo un modello più piccolo e meno costoso, è ideale per compiti tecnici rapidi che richiedono velocità ed efficienza, come la generazione di codice o l'analisi di dati semplici. Tuttavia, ha una conoscenza del mondo limitata rispetto a modelli più grandi, rendendolo meno adatto per compiti che richiedono una comprensione approfondita o contestuale.

Come si confronta GPT-4o mini con GPT-3.5 Turbo in termini di prestazioni e costi?

GPT-4o mini supera GPT-3.5 Turbo in termini di intelligenza testuale e ragionamento multimodale, ottenendo un punteggio dell'82% su MMLU rispetto al 69,8% di GPT-3.5 Turbo. Inoltre, è oltre il 60% più economico, con un costo di 15 centesimi per milione di token in input e 60 centesimi per milione di token in output.

Quali sono le implicazioni dell'integrazione di capacità multimodali in modelli come GPT-4o?

L'integrazione di capacità multimodali in modelli come GPT-4o consente un'interazione più naturale e intuitiva con gli utenti, permettendo al modello di comprendere e generare risposte in testo, immagini e audio. Questo amplia le applicazioni dell'IA in settori come l'assistenza clienti, l'educazione e la creazione di contenuti multimediali.

In che modo l'intelligenza artificiale sta trasformando l'industria del software?

L'intelligenza artificiale sta rivoluzionando l'industria del software automatizzando la generazione di codice, migliorando la risoluzione di problemi complessi e aumentando l'efficienza degli sviluppatori. Modelli avanzati come GPT-4.1 e o4-mini hanno mostrato miglioramenti significativi nella capacità di risolvere problemi di programmazione, indicando un futuro in cui l'IA sarà un complemento essenziale nello sviluppo software.