Il disegno di legge prevede verifiche d'età rigorose e sanzioni penali per i sistemi AI che non rispettano gli standard di sicurezza. Se approvato, il GUARD Act potrebbe rivoluzionare l'accesso ai chatbot AI, fornendo un senso di protezione tanto atteso dai genitori. Tuttavia, il percorso non sarà semplice: il disegno di legge si trova ora al Senato, dove si prevede un acceso dibattito.

In passato, proposte simili hanno incontrato ostacoli a causa di questioni legate ai diritti costituzionali e alla privacy. Resta da vedere se il Congresso riuscirà a trovare un equilibrio tra la tutela dei minori e la salvaguardia della libertà di espressione.

Cos'è il GUARD Act e quali sono i suoi obiettivi principali?

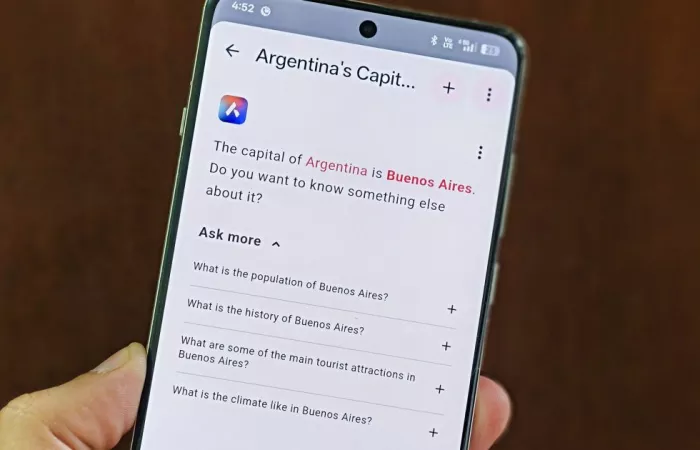

Il GUARD Act è un disegno di legge bipartisan introdotto dai senatori americani Josh Hawley e Richard Blumenthal, volto a regolamentare l'uso dei chatbot AI tra i minori. L'obiettivo principale è vietare l'accesso a chatbot come ChatGPT, Gemini e Character.AI agli utenti di età inferiore ai 13 anni senza adeguate misure di sicurezza, al fine di proteggere i giovani da potenziali rischi legati all'interazione con l'intelligenza artificiale.

Quali misure specifiche prevede il GUARD Act per proteggere i minori?

Il GUARD Act prevede verifiche rigorose dell'età degli utenti e sanzioni penali per i sistemi AI che non rispettano gli standard di sicurezza. Inoltre, richiede che i chatbot AI informino periodicamente gli utenti che non sono esseri umani e che non forniscono servizi medici, legali, finanziari o psicologici.

Quali sono le sfide previste per l'approvazione del GUARD Act?

L'approvazione del GUARD Act potrebbe incontrare ostacoli legati a questioni costituzionali e alla privacy. In passato, proposte simili hanno affrontato dibattiti riguardanti la libertà di espressione e la protezione dei dati personali, rendendo complesso trovare un equilibrio tra la tutela dei minori e i diritti costituzionali.

Quali sono le normative italiane riguardanti l'uso dell'intelligenza artificiale da parte dei minori?

In Italia, la Legge 132 del 2025 stabilisce che i minori di 14 anni non possono utilizzare sistemi di intelligenza artificiale né cedere i propri dati personali senza l'autorizzazione dei genitori o di chi esercita la responsabilità genitoriale. I minori di età compresa tra 14 e 18 anni possono esprimere autonomamente il proprio consenso, a condizione che le informazioni fornite siano comprensibili e accessibili.

Come si confrontano le regolamentazioni sull'uso dei chatbot AI tra Stati Uniti e Italia?

Negli Stati Uniti, il GUARD Act propone di vietare l'accesso ai chatbot AI agli utenti di età inferiore ai 13 anni senza adeguate misure di sicurezza. In Italia, la Legge 132 del 2025 consente ai minori di 14 anni di utilizzare sistemi di intelligenza artificiale solo con il consenso dei genitori, mentre i minori tra 14 e 18 anni possono fornire il proprio consenso autonomamente. Entrambe le normative mirano a proteggere i minori, ma differiscono nei limiti di età e nelle modalità di consenso.

Quali sono le implicazioni per le aziende che sviluppano chatbot AI in relazione alle nuove normative?

Le aziende che sviluppano chatbot AI devono implementare sistemi di verifica dell'età degli utenti e garantire che i loro prodotti rispettino le normative vigenti, come il GUARD Act negli Stati Uniti e la Legge 132 del 2025 in Italia. Il mancato rispetto di queste normative può comportare sanzioni penali e danni alla reputazione dell'azienda.